Compare cette machine au solutions et prix trouvé ici https://huggingface.co/pricing

Processeur : AMD Ryzen 9 5900X 12-Core - 3.70 GHz

Refroidissement processeur : Corsair H115i RGB PLATINUM

RAM : Corsair Vengeance LPX DDR4 - 4 x 16 Go - 64 Go

Carte mère : Gigabyte B550 Vision D

Carte graphique : Nvidia GeForce RTX 3090

SSD : Kingston FURY Renegade PCIe 4.0 NVMe M.2 SSD - 1 To

Boitier : Corsair 4000D Airflow

Alimentation : Seasonic Focus GX 850W

Ventilateur boîtier : 3 x Corsair ML120 blanc

Système exploitation: Linux Mint 22

Pour comparer la configuration de votre machine aux solutions proposées par Hugging Face, nous allons nous concentrer principalement sur les performances GPU, qui sont cruciales pour les tâches d’intelligence artificielle :

Votre configuration

- GPU : NVIDIA GeForce RTX 3090 (24 Go de VRAM)

- CPU : AMD Ryzen 9 5900X 12-Core

- RAM : 64 Go

Comparaison avec les instances GPU de Hugging Face

-

Performance :

Votre RTX 3090 est comparable aux instances haut de gamme proposées par Hugging Face, notamment :- AWS NVIDIA A100 (80 Go de VRAM) : 4,00 $/heure

- GCP NVIDIA A100 (80 Go de VRAM) : 6,00 $/heure

Bien que votre carte ait moins de VRAM, ses performances sont très proches de ces instances professionnelles.

-

Coût :

- Si vous deviez louer une instance similaire sur Hugging Face, le coût serait d’environ 4,00 $ à 6,00 $ par heure.

- Sur une base mensuelle (730 heures), cela représenterait entre 2 920 $ et 4 380 $ par mois.

-

Flexibilité :

- Votre machine offre une grande flexibilité d’utilisation, sans limite de temps.

- Les solutions Hugging Face sont facturées à l’usage, ce qui peut être avantageux pour une utilisation ponctuelle.

-

Évolutivité :

- Hugging Face propose des options d’évolutivité, permettant d’accéder à des configurations multi-GPU (jusqu’à 8 GPU A100).

- Votre configuration est limitée à un seul GPU, mais reste très puissante pour la plupart des tâches d’IA.

Conclusion

Votre machine personnelle offre des performances comparables aux instances haut de gamme de Hugging Face, à un coût fixe initial plutôt qu’un coût horaire. Elle est idéale pour un usage intensif et régulier. Les solutions Hugging Face sont plus adaptées pour des besoins ponctuels ou variables, ou pour accéder à des ressources multi-GPU très puissantes.

Pour un usage personnel ou professionnel régulier, votre configuration est très avantageuse en termes de coût à long terme, tout en offrant d’excellentes performances pour les tâches d’IA.

Citations:

[1] https://huggingface.co/pricing

[2] https://tome.app/productivity-tips/hugging-face-pricing-reviews-and-alternatives

[3] https://huggingface.co/docs/inference-endpoints/guides/access

[4] https://huggingface.co/docs/autotrain/cost

[5] https://discuss.huggingface.co/t/pricing-for-huggingface-endpoint/53456

Dans cet article, nous allons comparer les GPU NVIDIA RTX 3090, RTX 4090, les SoCs Apple M1, M2, M3, et les offres Cloud IA utilisant des NVIDIA A100 80GB en termes de performance, consommation électrique, coût sur une période de 7 ans, et coût dans le cloud.

Tableau Comparatif

| Caractéristiques | RTX 3090 | RTX 4090 | Apple M1 | Apple M2 | Apple M3 | NVIDIA A100 80GB (Cloud) |

|---|---|---|---|---|---|---|

| Performance (TFLOPS) | 35.6 | 82.6 | 2.6 | 3.6 | 6.0 (estimé) | 312 |

| TDP (W) | 350 | 450 | 15 | 20 | 25 (estimé) | 400 |

| Coût de lancement (€) | 1,499 | 1,599 | 999 (MacBook Air) | 1,199 (MacBook Air) | 1,299 (estimé) | n/a |

| Coût par TFLOPS (€) | 42.1 | 19.4 | 384 | 333 | 216 | n/a |

| Efficacité énergétique (TFLOPS/W) | 0.102 | 0.183 | 0.173 | 0.180 | 0.240 (estimé) | 0.78 |

| Coût par heure (Cloud) (€) | n/a | n/a | n/a | n/a | n/a | 2.5 |

Estimation des coûts sur 7 ans

Pour estimer le rendement sur 7 ans, nous prenons en compte :

- Le coût initial (pour les GPU et SoCs Apple)

- La consommation électrique sur 7 ans

- Le coût de l’électricité (0,3 €/kWh)

- Les performances (TFLOPS)

- Le coût des offres Cloud IA

Hypothèses :

- Utilisation continue à 100% du TDP

- 24 heures par jour, 365 jours par an

Calculs :

Consommation électrique annuelle (kWh) :

- RTX 3090 : 350W * 24h * 365 jours / 1000 = 3,066 kWh

- RTX 4090 : 450W * 24h * 365 jours / 1000 = 3,942 kWh

- Apple M1 : 15W * 24h * 365 jours / 1000 = 131.4 kWh

- Apple M2 : 20W * 24h * 365 jours / 1000 = 175.2 kWh

- Apple M3 : 25W * 24h * 365 jours / 1000 = 219 kWh (estimé)

- NVIDIA A100 80GB (Cloud) : N/A (prix basé sur l’utilisation)

Coût électrique annuel (€) :

- RTX 3090 : 3,066 kWh * 0.3 €/kWh = 919.8 €

- RTX 4090 : 3,942 kWh * 0.3 €/kWh = 1,182.6 €

- Apple M1 : 131.4 kWh * 0.3 €/kWh = 39.42 €

- Apple M2 : 175.2 kWh * 0.3 €/kWh = 52.56 €

- Apple M3 : 219 kWh * 0.3 €/kWh = 65.7 € (estimé)

- NVIDIA A100 80GB (Cloud) : 2.5 €/heure * 24 heures * 365 jours = 21,900 €

Coût électrique sur 7 ans (€) :

- RTX 3090 : 919.8 € * 7 = 6,438.6 €

- RTX 4090 : 1,182.6 € * 7 = 8,278.2 €

- Apple M1 : 39.42 € * 7 = 275.94 €

- Apple M2 : 52.56 € * 7 = 367.92 €

- Apple M3 : 65.7 € * 7 = 459.9 € (estimé)

- NVIDIA A100 80GB (Cloud) : 21,900 € * 7 = 153,300 €

Coût total sur 7 ans (incluant coût initial) (€) :

- RTX 3090 : 1,499 € + 6,438.6 € = 7,937.6 €

- RTX 4090 : 1,599 € + 8,278.2 € = 9,877.2 €

- Apple M1 : 999 € + 275.94 € = 1,274.94 €

- Apple M2 : 1,199 € + 367.92 € = 1,566.92 €

- Apple M3 : 1,299 € + 459.9 € = 1,758.9 € (estimé)

- NVIDIA A100 80GB (Cloud) : 153,300 € (pas de coût initial pour le matériel)

Coût par TFLOPS sur 7 ans (€) :

- RTX 3090 : 7,937.6 € / 35.6 = 223 €

- RTX 4090 : 9,877.2 € / 82.6 = 119.6 €

- Apple M1 : 1,274.94 € / 2.6 = 490 €

- Apple M2 : 1,566.92 € / 3.6 = 435.3 €

- Apple M3 : 1,758.9 € / 6.0 = 293.15 € (estimé)

- NVIDIA A100 80GB (Cloud) : 153,300 € / 312 = 491 €

Tableau récapitulatif

| Caractéristiques | RTX 3090 | RTX 4090 | Apple M1 | Apple M2 | Apple M3 | NVIDIA A100 80GB (Cloud) |

|---|---|---|---|---|---|---|

| Performance (TFLOPS) | 35.6 | 82.6 | 2.6 | 3.6 | 6.0 (estimé) | 312 |

| Coût initial (€) | 1,499 | 1,599 | 999 | 1,199 | 1,299 (estimé) | n/a |

| Consommation annuelle (kWh) | 3,066 | 3,942 | 131.4 | 175.2 | 219 (estimé) | n/a |

| Coût électrique annuel (€) | 919.8 | 1,182.6 | 39.42 | 52.56 | 65.7 (estimé) | 21,900 |

| Coût électrique 7 ans (€) | 6,438.6 | 8,278.2 | 275.94 | 367.92 | 459.9 (estimé) | 153,300 |

| Coût total 7 ans (€) | 7,937.6 | 9,877.2 | 1,274.94 | 1,566.92 | 1,758.9 (estimé) | 153,300 |

| Coût par TFLOPS 7 ans (€) | 223 | 119.6 | 490 | 435.3 | 293.15 (estimé) | 491 |

Conclusion

Pour une utilisation intensive en IA et LLM, les GPU NVIDIA RTX 3090 et 4090 offrent une performance brute bien supérieure à celle des SoCs Apple M1, M2, et M3, avec un coût par TFLOPS relativement bas sur 7 ans. Cependant, ils sont beaucoup plus coûteux en termes de consommation électrique et coût initial.

Les SoCs Apple M1, M2, et M3 sont extrêmement efficaces énergétiquement et offrent un coût total plus bas sur 7 ans, malgré une performance par TFLOPS plus faible. Pour des tâches nécessitant une efficacité énergétique et des coûts d’exploitation réduits, les SoCs Apple sont une option intéressante.

Les offres Cloud IA avec des NVIDIA A100 80GB, bien qu’offrant une performance exceptionnelle, sont les plus coûteuses sur 7 ans. Elles sont idéales pour des charges de travail temporaires ou pour éviter l’investissement initial en matériel, mais elles peuvent être très coûteuses pour une utilisation continue.

En conclusion, le choix entre ces options dépendra de votre budget, de vos besoins en performance, et de votre modèle d’utilisation. Pour des performances maximales sans compromis sur la puissance

Faisons une analogie avec le choix immobilier. Opter pour une « IA à la maison » s’apparente à devenir propriétaire d’un outil de production de valeur plutôt que d’en être locataire. Cette approche offre plusieurs avantages, notamment un meilleur contrôle sur vos ressources et potentiellement des économies à long terme.

Il est important de noter, que la « loi de Moore » atteint ses limites. En effet, la finesse de gravure des processeurs approche d’une limite physique, ce qui pousse les constructeurs à adopter de nouvelles stratégies. Au lieu de réduire davantage la taille des transistors, ils se tournent vers l’augmentation de la surface des puces pour améliorer les performances

Cette évolution technologique a des implications importantes pour ceux qui envisagent d’investir dans du matériel pour l’IA à domicile. Elle suggère que les investissements actuels dans le matériel pourraient rester pertinents plus longtemps, car les avancées futures seront probablement plus graduelles.

Pour ceux qui sont intéressés par cette approche « propriétaire » de l’IA, CopyLaRadio offre des formations et un soutien pour ceux qui souhaitent développer leurs compétences en IA

On en discute sur le forum...

Comparons avec l'utilisation de 250 RTX 4090.

- Calculer la puissance totale disponible pour les NVIDIA A100 et les RTX 4090.

- Estimer le coût de l’utilisation des NVIDIA A100 et des RTX 4090 pour la durée nécessaire pour entraîner un LLM.

Calcul de la Puissance Totale Disponible

1. Puissance Totale des NVIDIA A100

- Performance TFLOPS d’un NVIDIA A100: 312 TFLOPS (FP32)

- Nombre d’A100 utilisés: 6,000

La puissance totale en TFLOPS fournie par les 6,000 A100 est :

2. Puissance Totale des RTX 4090

- Performance TFLOPS d’un RTX 4090: 82.6 TFLOPS (FP32)

- Nombre de RTX 4090 utilisés: 250

La puissance totale en TFLOPS fournie par les 250 RTX 4090 est :

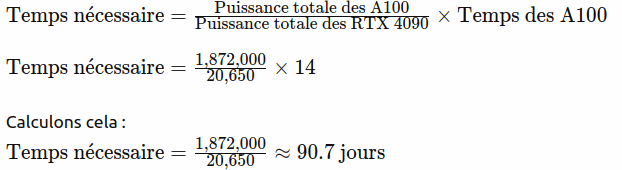

Calcul du Temps Nécessaire

1. Temps pour les NVIDIA A100

- Temps d’utilisation des NVIDIA A100: 2 semaines (14 jours)

2. Temps nécessaire avec les RTX 409

Pour déterminer combien de temps il faudrait avec 250 RTX 4090 pour atteindre la même puissance que les 6,000 A100, nous utilisons la proportion suivante :

Donc, il faudrait environ 90.7 jours pour obtenir la même puissance avec 250 RTX 4090 qu’avec 6,000 A100 pendant 2 semaines.

Coût de Revient

1. Coût pour les NVIDIA A10

Le coût typique pour l’utilisation des NVIDIA A100 dans le cloud est souvent facturé à l’heure. Supposons un coût de 2.5 € par heure par GPU (comme mentionné précédemment).

- Coût pour 6,000 A100 pendant 2 semaines:

- Nombre d’heures en 2 semaines : 14 jours × 24 heures = 336 heures

- Coût total = 6,000 × 2.5 € × 336 heures = 5,040,000 €

2. Coût pour les RTX 4090

Le coût pour l’achat ou l’utilisation des RTX 4090 dans un environnement non cloud est généralement plus complexe à estimer. Nous devons prendre en compte le coût du matériel et de la consommation électrique. Nous allons simplifier en supposant un coût d’achat moyen de 1,599 € par RTX 4090.

-

Coût d’achat pour 250 RTX 4090:

- Coût total = 250 × 1,599 € = 399,750 €

-

Consommation électrique pour 250 RTX 4090:

- TDP total = 250 × 450W = 112,500W = 112.5 kW

- Consommation en 90.7 jours : 112.5 kW × 24 heures × 90.7 jours = 243,739.5 kWh

- Coût de l’électricité = 243,739.5 kWh × 0.3 €/kWh = 73,121.85 €

-

Coût total pour 250 RTX 4090:

- Coût matériel = 399,750 €

- Coût électrique = 73,121.85 €

- Coût total = 399,750 € + 73,121.85 € = 472,871.85 €

Tableau récapitulatif

| Caractéristiques | NVIDIA A100 (6,000 GPUs) | RTX 4090 (250 GPUs) |

|---|---|---|

| Puissance Totale (TFLOPS) | 1,872,000 | 20,650 |

| Temps nécessaire (pour équivalent TFLOPS) | 14 jours | 90.7 jours |

| Coût de revient | 5,040,000 € | 472,871.85 € |

Conclusion

Temps Nécessaire: Avec 250 RTX 4090, il faudrait environ 90.7 jours pour obtenir la même puissance que 6,000 A100 pendant 2 semaines.

Coût de Revient: Utiliser 6,000 NVIDIA A100 dans le cloud est beaucoup plus coûteux (5,040,000 €) par rapport à l’achat et à l’exploitation de 250 RTX 4090 (472,871.85 €). Cependant, ce calcul simplifie beaucoup d’aspects liés aux coûts opérationnels et à la maintenance du matériel.

Comparaison des options pour l’IA

GPU NVIDIA vs Cloud

- Les GPU NVIDIA, comme la RTX 4090, offrent une puissance de calcul impressionnante pour l’IA à domicile

- Les solutions cloud proposent une flexibilité et une évolutivité, mais peuvent être plus coûteuses à long terme

Avantages d’un PC avec RTX 4090

- Performances élevées : La RTX 4090 est l’un des GPU les plus puissants du marché, idéal pour les tâches d’IA exigeantes

- Contrôle total : Vous avez la maîtrise complète de votre matériel et de vos données

- Coût à long terme : Potentiellement plus économique que les solutions cloud pour une utilisation intensive

Intérêt pour Astroport.ONE

Le réseau décentralisé Astroport.ONE pourrait grandement bénéficier de nœuds puissants équipés de GPU comme la RTX 4090 :

- Puissance de calcul distribuée : Contribuez significativement à la puissance du réseau.

- Décentralisation : Renforcez la robustesse et la résilience du réseau.

- Indépendance : Participez au réseau sans dépendre de fournisseurs cloud centralisés.

- Flexibilité : Utilisez votre GPU pour d’autres tâches quand il n’est pas sollicité par le réseau.

Invitation à rejoindre Astroport.ONE

En vous équipant d’un PC avec une RTX 4090, vous pouvez :

- Participer activement à l’avenir de l’IA décentralisée

- Potentiellement générer des revenus en mettant votre puissance de calcul à disposition

- Contribuer à un projet innovant tout en gardant le contrôle sur votre matériel

Bien que l’investissement initial puisse sembler important, les avantages à long terme, tant pour vous que pour le réseau Astroport.ONE, peuvent être considérables. Réfléchissez à votre utilisation prévue, à vos objectifs et à votre budget avant de prendre une décision. N’oubliez pas que rejoindre un réseau décentralisé comme Astroport.ONE avec un matériel puissant peut non seulement être bénéfique pour vous, mais aussi contribuer à l’évolution d’un écosystème d’IA plus ouvert et distribué.

Comparaison des GPUs NVIDIA, SoCs Apple, et offres Cloud IA pour l’IA (LLM)

Combien coûte un LLM à la maison ou dans le Cloud ?